Deepfakes – Wenn Videobeweise lügen

Risiken im Internet

Man darf nicht alles glauben, was man im Internet sieht – auch nicht, wenn man es selbst in einem Video sieht. Sogenannte Deepfakes, mit künstlicher Intelligenz gefälschte Medieninhalte, tummeln sich immer häufiger auf Social Media und anderswo im Web. Oft, um falsche Informationen zu verbreiten. Deepfakes sind nicht nur für Promis und Politiker ein Problem.

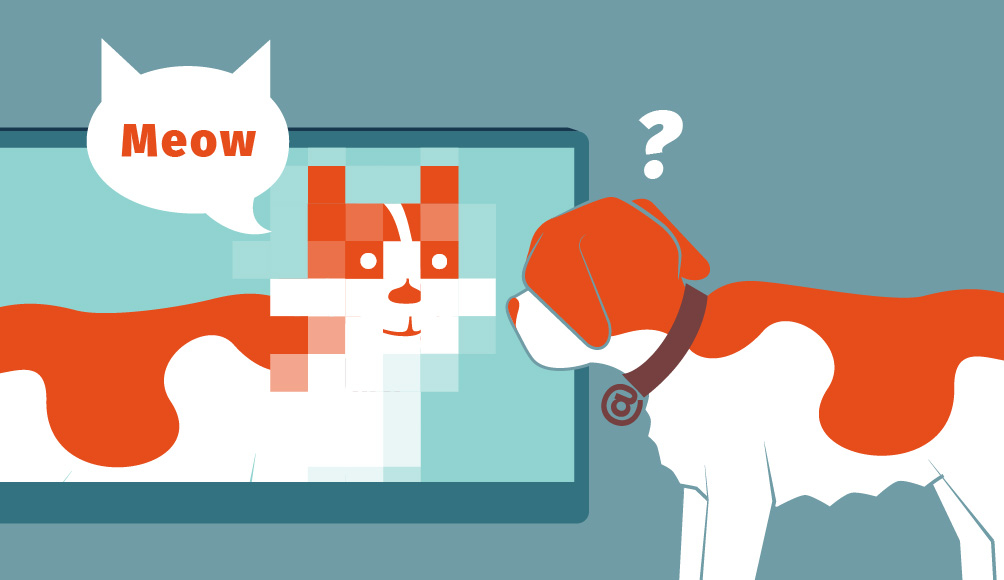

Wenn man etwas im Internet findet und den Augen kaum glaubt, hat man es wahrscheinlich mit einem Deepfake zu tun. Das Wort ist eine Kombination von „Deep Learning“ und „Fake“ – dem englischen Wort für eine Fälschung. Deep Learning ist eine Form der künstlichen Intelligenz (KI). Dabei „lernt“ eine KI aus Beispielen und kann das Gelernte anschliessend nachahmen. Genau das machen Deepfakes. Zuerst lernt die KI etwa, wie das Gesicht einer Person aussieht. Anschliessend kann das Gesicht in einem beliebigen Video eingefügt werden.

Deepfakes kommen in verschiedenen Formen daher:

- Austauschen eines Gesichts

- Austauschen der Lippen (damit es so wirkt, als spreche die Person einen anderen Text)

- Nachahmung der Stimme einer Person

- Digitale Avatare (komplett künstlich erschaffenes Gesicht und Stimme)

Ein Deepfake selbst ist noch nichts Kriminelles. Zu den legalen Anwendungen gehören etwa:

- Film- und TV-Produktionen zu Unterhaltungszwecken (siehe Beispiele am Ende des Beitrags).

- Umsetzungen für Kunstwerke oder Satire.

- Anwendungen in der wissenschaftlichen Forschung.

- Integration in Videokonferenzlösungen, um den Bandbreitenbedarf zu senken.

Obwohl Deepfakes nicht illegal sind, kann man trotzdem damit gegen Gesetze verstossen – vor allem im Bereich des Datenschutzes und des Urheberrechts. Oftmals werden Deepfakes aber sogar für klar fragwürdige oder illegale Absichten genutzt. Dazu zählen:

- Pornographie: Sehr viele Deepfakes sind pornographischer Natur. Dabei werden die Gesichter von Personen – etwa bekannten Schauspieler*innen oder Ex-Partner*innen – in pornographische Inhalte eingefügt.

- Fake News: Die Verbreitung von Falschinformationen und „Fake News“ beispielsweise bei Wahlen oder jetzt aktuell im Krieg in der Ukraine.

- CEO Scam: Deepfakes bringen auch CEO Scams auf das nächste Level: Cyberkriminelle ahmen etwa die Stimme des CEOs einer Firma nach und versuchen telefonisch beispielsweise eine Zahlung auszulösen.

- Falsche Bewerbende: Deepfakes kommen auch bei Online-Bewerbungsgesprächen zum Einsatz. Cyberkriminelle verhüllen so ihre Identität, während sie versuchen, Zugang zu Kunden- oder Firmendaten zu verschaffen.

- Erpressung: Mit Deepfakes lassen sich Bilder und Videos erstellen, die angeblich Personen bei unsittlichem oder illegalem Verhalten zeigen, um diese damit zu erpressen.

Aktuell sind die Anzahl Fälle, bei denen Deepfakes für cyberkriminelle Machenschaften genutzt wurden, noch sehr überschaubar. Die Technologie entwickelt sich jedoch schnell weiter. Die erforderliche Rechenleistung nimmt stetig ab. Und die Qualität wird immer besser. Es ist daher naheliegend anzunehmen, dass die Probleme rund um Deepfakes zunehmen werden.

Wie man Deepfakes erkennt

Eine gesunde Portion Skepsis kann helfen, auch im Zeitalter von Deepfakes sicher zu bleiben. Egal was man sieht und hört: Nur was sich verifizieren lässt, ist wirklich wahr. Aufgrund des aktuellen Standes der Technologie sind Deepfakes – zumindest im Moment noch – erkennbar, wenn man genau hinschaut. Wer denkt, ein Deepfake vor sich zu haben, sollte auf die folgenden Punkte achten:

- Gesunder Menschenverstand: Ergibt es Sinn, dass die Person in einem Video tut, was sie tut? Wenn etwas im Internet suspekt wirkt, lohnt es sich in der Regel, das Gefundene zuerst zu prüfen, bevor man es teilt.

- Unnatürliche Kopfbewegungen: Das Gesicht scheint sich oft leicht unabhängig vom Rest des Kopfes zu bewegen. Dies wirkt ungewohnt oder unnatürlich (Uncanny Valley).

- Genau hinschauen: Rasche Bewegungen gehen bei der Videobearbeitung manchmal unter. Das heisst, ein Husten oder ein Niesen ist zwar zu hören, die dazugehörige Gesichtsbewegung ist aber nicht zu sehen.

- Details: Da Deepfakes automatisch generiert werden, zeigen sich oft Unregelmässigkeiten bei kleinen Details, wie etwa Brillen, Gesichtsschmuck oder Lichtreflexionen in den Augen der abgebildeten Personen.

- Frame by Frame: Schaut man sich ein Video Bild für Bild an, fallen die Ungereimtheiten deutlich schneller auf.

- Den Kopf drehen: Zweifelt man am Gegenüber in einer Videokonferenz, sollte man die Person auffordern, den Kopf komplett zur Seite zu drehen. In der Regel weiss das Deepfake dann nicht mehr, wo es das Gesicht im Bild richtig einfügen soll.

- Faktencheck: Findet man ein potenzielles Deepfake-Video auch auf vertrauenswürdigen News-Websites? Oder findet man vielleicht dasselbe, nicht bearbeitete Video, wenn man eine Beschreibung des Videos googelt?

Verschiedene Hochschulen verkünden bereits Erfolge bei der automatischen Erkennung von Deepfakes. Ein Team des Information Sciences Institute der University of Southern California beispielsweise erkennt Deepfakes mit einer Trefferquote von 96 Prozent.

Und wie verhindert man, dass man selbst Opfer eines Deepfakes wird?

Ein überzeugendes Deepfake erfordert eine Fülle an Bild- und Ton-Material der zu fälschenden Person. Wer also das eigene Gesicht einzigartig halten will, sollte nicht zu viel von sich selbst online stellen. Gibt es keine oder nur unvollständige Aufnahmen der Stimme oder des Gesichts einer Person, kann keine KI diese nachahmen.

Weitere Informationen

YouTube

Deepfakes bei Star WarsYouTube

Musikvideo „The Heart Part 5“ von Kendrick LamarUSC Information Sciences Institute, USA

Forschungsarbeit zur Erkennung von Deepfakes mittels KICornell University

Methode zur Erkennung von Deepfakes anhand Unregelmässigkeiten in den Lichtreflexionen